论文精读——SRGAN

2024年10月28日大约 2 分钟

论文精读——SRGAN

引入

- 在图像超分引入GAN网络

- 引入新的图像评价指标——利用VGG提取超分/原始图像特征,对这些特征进行比较

- 综合了GAN(判别器)+ 指标图像评价指标提出新的损失函数

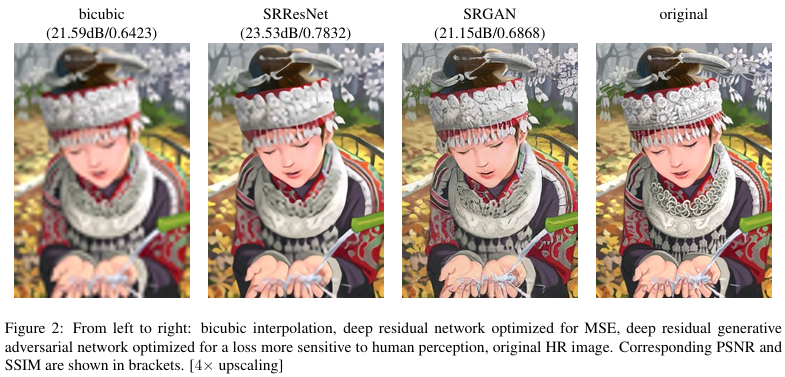

- MOS测试——并不简单基于MSE评价图像质量,更多考虑肉眼感知质量

Abstract

1. Introduction

PSNR高不代表肉眼感知质量更高,其余略

PSNR高不代表肉眼感知质量更高,其余略

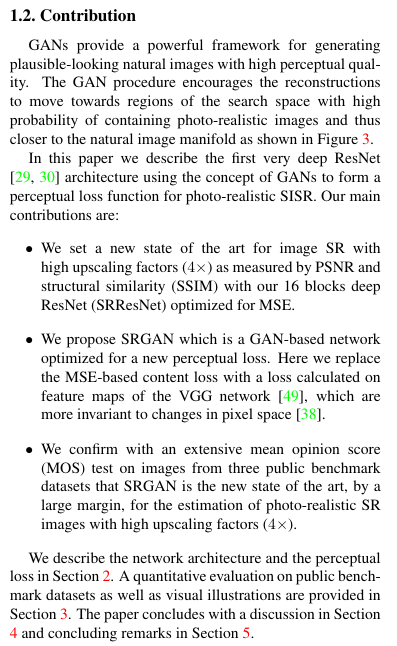

1.2. Contribution

- 训练了更深更好的SRResNet

- 提出SRGAN

- 提出MOS与新的损失函数

1.1. Related work

传统图像超分技术等

2. Method

: 生成器 : low_resolution image 低分图像 : high_resolution image 高分图像(原始图像) : 损失函数

: 生成器 : low_resolution image 低分图像 : high_resolution image 高分图像(原始图像) : 损失函数

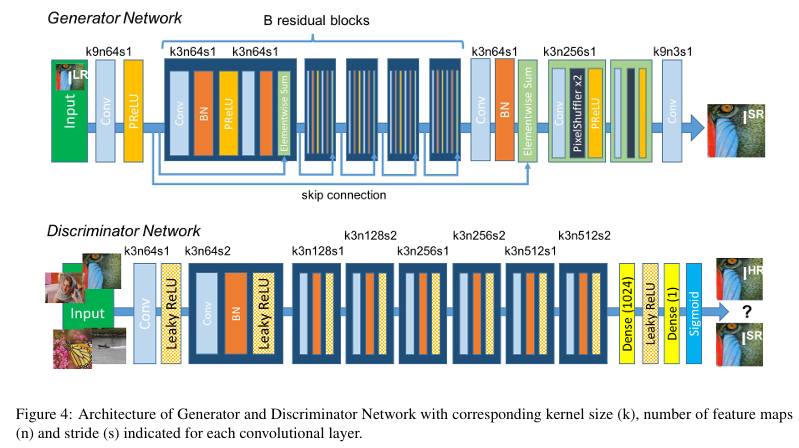

2.1. Adversarial network architecture

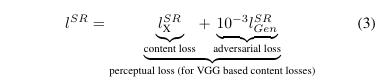

2.2. Perceptual loss function

图像内容loss + GAN网络对抗loss(加权求和)

图像内容loss + GAN网络对抗loss(加权求和)

2.2.1 Content loss

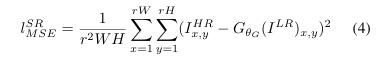

作者列举了两种:  传统MSE

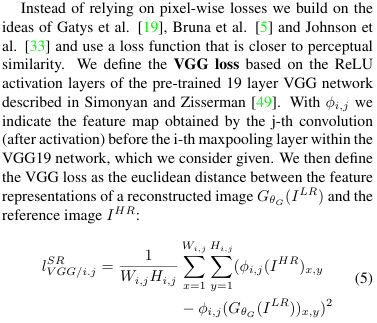

传统MSE  利用VGG网络得到特征图,计算特征图间的欧氏距离

利用VGG网络得到特征图,计算特征图间的欧氏距离

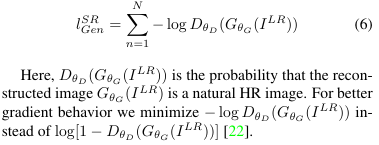

2.2.2 Adversarial loss

3. Experiments

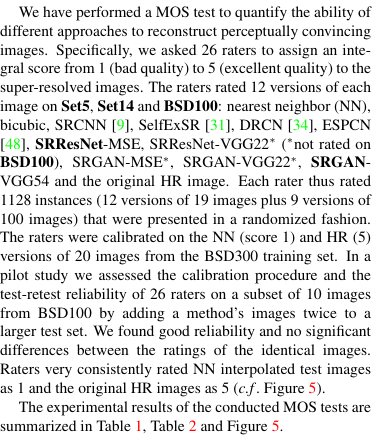

3.3. Mean opinion score (MOS) testing

找志愿者用肉眼评判图像质量/分辨率

找志愿者用肉眼评判图像质量/分辨率

4. Discussion and future work

“We speculate that feature maps of these deeper layers focus purely on the content while leaving the adversarial loss focusing on texture details. 我们推测,这些较深层的特征图纯粹关注内容,而将对抗性损失集中在纹理细节上。” loss函数综合考虑了图像的整体内容和纹理细节。

“We speculate that feature maps of these deeper layers focus purely on the content while leaving the adversarial loss focusing on texture details. 我们推测,这些较深层的特征图纯粹关注内容,而将对抗性损失集中在纹理细节上。” loss函数综合考虑了图像的整体内容和纹理细节。

5. Conclusion